الگوریتمهای تبعیضآمیز: پنج نمونه از پیشداوریهای هوش مصنوعی

هوش مصنوعی قرار است زندگی را برای همهی ما آسانتر کند، این پدیده اما مستعد افزایش سوگیریهای جنسیتزده و نژادپرستانه نیز است.

زندگی مدرن بر پایهی الگوریتمهای هوشمند جریان دارد. برنامههای کامپیوتری خودارتقادهنده که دادهها را میبلعند و بستر انقلاب هوش مصنوعی هستند همین حالا هم نتایج جستجوی گوگل، فید خبری فیسبوک و پیشنهادهای خرید آنلاین را تعیین میکنند. حتی بیشتر از این، تصمیم میگیرند با چه سهولتی وام و یا یک مصاحبهی کاری بگیریم، احتمال توقیف ماشین و گشته شدن توسط پلیس در راه خانه، و همچنین اینکه اگر مرتکب جرمی شویم با چه مجازاتهایی روبرو خواهیم شد.

پس بر این اساس باید در تصمیمگیریهایشان بری از خطا باشند، درست است؟ خیر، اشتباه است. دادههای ورودی منحرفشده، منطق اشتباه یا تنها پیشداوریهای برنامهنویسان آنها به این معنی هستند که هوشهای مصنوعی هم بهراحتی سوگیریهای انسانی را بازتولید و حتی تشدید میکنند. پنج مثالی که در ادامه میآیند موید همین نکته هستند.

۱. تبعیض نژادی در الگوریتم کامپِس

کامپس[۱] الگوریتمیست که با پیشبینی احتمال ارتکاب مجدد جرم برای هدایت روند صدور حکم بهطور گسترده در آمریکا استفاده میشود. احتمالا در بدآوازهترین نمونهی پیشداوری هوش مصنوعی، در ماه مه سال ۲۰۱۶ سازمان خبری غیرانتفاعی پروپوبلیکا[۲] گزارش داد که کامپس از نظر نژادی جانبدارانه است. طبق تحلیل پروپوبلیکا، سیستم ریسک ارتکاب مجدد جرم توسط متهمان سیاهپوست را بیشتر در نظر گرفته و عکس این حالت را برای متهمان سفیدپوست متصور میشود. اِکویونت[۳]، شرکت توسعهدهندهی نرمافزار، این مسئله را نمیپذیرد.

تشخیص واقعیت، یا اینکه جهتگیری از کجا ممکن است نشات بگیرد، دشوار است، چرا که الگوریتم در مالکیت انحصاری توسعهدهندگانش بوده و برای بررسی دقیق در دسترس نیست. اما در هر صورت، اگر مطالعهای که در ژانویهی سال ۲۰۱۸ در همین وبسایت منتشر شد را در نظر بگیریم، وقتی نوبت به پیشبینی دقیق اینکه احتمال ارتکاب مجدد جرم از جانب چه کسی بیشتر است میرسد، این الگوریتم بهتر از آدمهای آموزشندیدهای که بهصورت تصادفی انتخاب شدهاند عمل نمیکند.

۲. پیشداوریهای الگوریتم پرِدپال

پرِدپال[۴] که در چندین ایالت آمریکا از آن استفاده میشود، الگوریتمیست که با هدف کمک به کاهش سوگیریهای انسانی در حفظ نظم، برای پیشبینی زمان و مکان وقوع جرم طراحی شده است. اما در سال ۲۰۱۶، گروه تحلیل دادههای حقوق بشری[۵] به این پی برد که نرمافزار میتواند پلیس را به این سمت هدایت کند که بعضی از محلهها را به شکلی ناعادلانه هدف بگیرد. هنگامی که محققین شبیهسازیای از الگوریتم پرِدپال را در مورد جرائم مربوط به مواد مخدر در اوکلند کالیفرنیا ترتیب دادند، الگوریتم شبیهسازیشده مرتباً افسران پلیس را به سمت محلههایی میفرستاد که در آنها تعداد زیادی از اقلیتهای نژادی بودند، بدون توجه به میزان حقیقی جرم و جنایت در آن نواحی.

مدیرعامل پرِدپال در پاسخ اشاره میکند که دادههای جرائم مواد مخدر از رسیدن به آستانهی بیطرفی بازمانده و بنابراین در دنیای واقعی بهمنظور اجتناب از پیشداوری، از این نرمافزار برای پیشبینی جرائم مربوط به مواد مخدر استفاده نمیشود. با اینحال سورِش وِنکاتاسوبرامانیان[۶] استاد دانشگاه یوتا و همکارانش ثابت کردند از آنجایی که نرمافزار بیشتر از گزارشهای ضبطشده توسط پلیس یاد میگیرد تا از نرخ جرم واقعی، پرِدپال یک «حلقهی بازخورد» میسازد که میتواند سوگیریهای نژادی را تشدید کند.

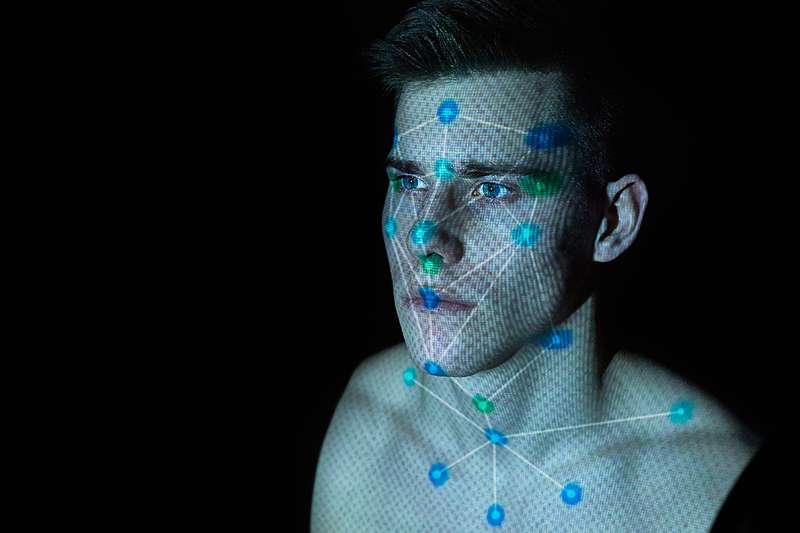

۳. تبعیض نژادی – جنسیتی در نرمافزارهای تشخیص چهره

نرمافزار تشخیص چهره که روز به روز بیشتر در نهادهای مجری قانون استفاده میشود نیز خاستگاه بالقوهی دیگریست برای سوگیریهای نژادی و جنسیتی. جوی باولاموینی[۷] در دانشگاه اِمآیتی به این مسئله پی برد که سه تا از جدیدترین هوشهای مصنوعی تشخیص جنسیت، متعلق به آیبیاِم، مایکروسافت و شرکت چینی مگوی[۸]، میتوانستند در ۹۹ درصد مواردْ جنسیت یک نفر را از روی عکس تشخیص بدهند – اما فقط برای مردان سفیدپوست. در مورد زنانِ با پوست تیره، دقت به تنها ۳۵ درصد کاهش مییافت. چیزی که خطر تشخیص اشتباه زنان و اقلیتها را افزایش میدهد. این مورد نیز احتمالاً به دادههایی که الگوریتمها بر اساس آنها پرورانده شدهاند برمیگردد: اگر به هر نحوی مردان سفیدپوست را بیشتر از زنان سیاهپوست دربرمیگیرد، در تشخیص مردان سفیدپوست موفقتر است. آیبیاِم بلافاصله اعلام کرد که سیستمش را با مجموعهای جدید از دادهها دوباره تعلیم داده و مایکروسافت گفت قدمهایی در جهت بهبود دقت برداشته است.

۴. تبعیض جنسیتی در تبلیغات گوگل

یک مطالعه در سال ۲۰۱۵ نشان داد که در قسمت جستجوی تصاویر گوگل برای واژهی «مدیرعامل»، تنها ۱۱ درصد از کسانی که نشان داده میشدند زن بودند، با اینکه ۲۷ درصد از مدیران عامل در آمریکا زن هستند. چند ماه بعد، آنوپام داتا[۹] از دانشگاه کارنگی ملونِ پتسبورگ طی تحقیقی به این موضوع پی برد که سیستم آنلاین تبلیغات گوگل، مشاغل با درآمد بالا را خیلی بیشتر به مردان نشان میداد تا به زنان.

گوگل به این نکته اشاره کرد که متصدیان تبلیغات میتوانند مشخص کنند تبلیغاتشان فقط به بعضی از کاربرها و یا در بعضی از وبسایتها نشان داده شوند. شرکت به مشتریانش اجازه میدهد که آگهیهایشان را بر اساس جنسیت هدفگیری کنند. اما داتا و همکارانش این ایده را نیز به ذهن متبادر میکنند که الگوریتم گوگل میتوانسته تعیین کند که مردان به خودی خود برای مناصب اجرایی مناسبتر هستند، این چیزی است که از رفتار کاربرانش آموخته: اگر تنها کسانی که آگهیهای مربوط به مشاغل پردرآمد را میبینند و روی آن کلیک میکنند مردان هستند، الگوریتم خواهد آموخت که آن آگهیها را فقط به مردان نشان بدهد.

۵. اشتباه فیسبوک در انتفاضه

گاهی اوقات هوش مصنوعی موجب شدت گرفتن سوگیری انسانی میشود. در اکتبر ۲۰۱۷، پلیس اسرائیل یک کارگر فلسطینی را که عکسی از خودش در مقابل یک بلدوزر با توضیح عبری «به آنها حمله کنید» در فیسبوک منتشر کرده بود بازداشت کرد. عبارت «صبح بخیر» به زبان عربی و «به آنها حمله کنید» به زبان عبری بسیار به هم شبیه هستند، و نرمافزار ترجمهی خودکار فیسبوک گزینهی اشتباه را انتخاب کرد. آن مرد برای ساعات متمادی تحت بازجویی بود تا اینکه یک نفر فهمید ایراد از کجاست. فیسبوک بلافاصله عذرخواهی کرد.

پی نوشت:

[۱] COMPAS

[۲] ProPublica

[۳] Equivant

[۴] PredPol

[۵] Human Rights Data Analysis Group

[۶] Suresh Venkatasubramanian

[۷] Joy Buolamwini

[۸] Megvii

[۹] Anupam Datta

منبع:

https://www.newscientist.com/article/2166207-discriminating-algorithms-5-times-ai-showed-prejudice/

مقاله خوبی بود اگر می تونستید که بیشتر در مورد الگوریتم های استفاده شده توضیح بدید خیلی بهتر بود